一大坨知识-10-ES

Elasticsearch可以实现 秒级 的搜索,cluster 是一种分布式的部署,极易扩展这样很容易使它处理PB级的数据库容量。最重要的是Elasticsearch是它搜索的结果可以按照分数进行排序,它能提供我们最相关的搜索结果(relevance)

1. 概述

特点

安装方便 :没有其他依赖,下载后安装非常方便;只用修改几个参数就可以搭建起来一个集群

JSON :输入/输出格式为 JSON,意味着不需要定义 Schema,快捷方便

RESTful :基本所有操作 ( 索引、查询、甚至是配置 ) 都可以通过 HTTP 接口进行

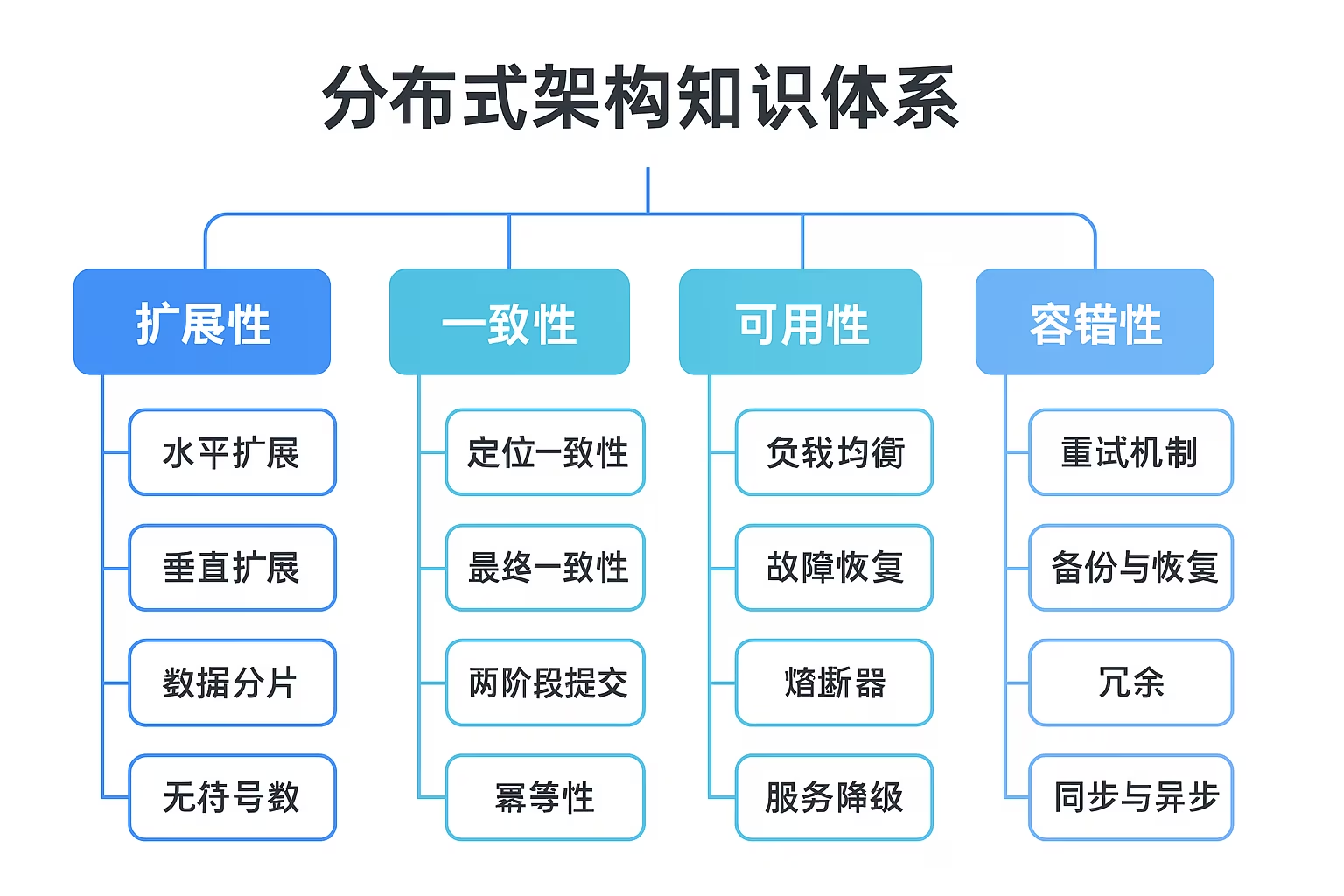

分布式 :节点对外表现对等(每个节点都可以用来做入口) 加入节点自动负载均衡

多租户 :可根据不同的用途分索引,可以同时操作多个索引

支持超大数据 : 可以扩展到 PB 级的结构化和非结构化数据 海量数据的近实时处理

功能

- 分布式的搜索引擎

分布式:Elasticsearch自动将海量数据分散到多台服务器上去存储和检索

- 全文检索

提供模糊搜索等自动度很高的查询方式,并进行相关性排名,高亮等功能

- 数据分析引擎(分组聚合)

社区网站,最近一周用户登录、最近一个月各功能使用情况

- 对海量数据进行近实时(秒级)的处理

海量数据的处理:因为是分布式架构,可以采用大量的服务器去存储和检索数据

场景

- 搜索类 场景

比如说人员检索、设备检索、App内的搜索、订单搜索。

- 日志分析 类场景

经典的ELK组合( Elasticsearch / Logstash / Kibana ),实现 日志收集 ,

日志存储 , 日志分析

- 数据预警平台 及数据分析场景

例如社区团购提示,当优惠的价格低于某个值时,自动触发通知消息,通知用户购买。

分析竞争对手商品销量Top10,供运营分析等等。

- **商业BI(Business Intelligence)**系统

比如社区周边,需要分析某一地区用户消费金额及商品类别,输出相应的报表数据,并预测该地区的热卖商品,通过区域和人群特征划分进行定向推荐。Elasticsearch执行数据分析和挖掘,Kibana做数据可视化。

竞品分析

Lucene

Java编写的信息搜索工具包(Jar包),Lucene只是一个框架,熟练运用Lucene非常复杂。

Solr

基于 Lucene 的HTTP接口查询服务器,是一个封装了很多Lucene细节搜索引擎系统

Elasticsearch

基于 Lucene 分布式海量数据近实时搜索引擎。采用的策略是将每一个字段都编入索引,使其可以被搜索。

对比

1)Solr利用Zookeeper进行分布式管理,而Elasticsearch自身带有分布式协调管理功能

2)Solr比Elasticsearch实现更加全面,而Elasticsearch本身更注重于核心功能, 高级功能多由第三方插件提供

3)Solr在传统的搜索应用中表现好于Elasticsearch,而Elasticsearch在实时搜索应用方面比Solr表现好

目前主流依然是 Elasticsearch 7.x 最新的是7.8

优化: 默认集成JDK 、升级Lucene8大幅提升 TopK性能 、引入熔断机制 避免OOM 发生

2. 基本概念

IK分词器

IKAnalyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。新版本的IKAnalyzer3.0则发展为

面向Java的公用分词组件,独立于Lucene项目,同时提供了对Lucene的默认优化实现。

IK分词器3.0的特性如下:

- 采用了特有的“正向迭代 最细粒度 切分算法“,具有 60万 字/秒的高速处理能力。

- 采用了 多子处理器 分析模式,支持:英文字母(IP地址、Email、URL)、数字(日期,常用中文数量词,罗马数字,科学计数法),中文词汇(姓名、地名处理)等分词处理。

- 支持 个人词条的优化 的词典存储,更小的内存占用。

- 针对Lucene 全文检索优化 的查询分析器IKQueryParser;采用歧义分析算法优化查询关键字的搜索

- 排列组合,能极大的提高Lucene检索的命中率。

- 扩展词典 :ext_dict

- 停用词典 :stop_dict

- 同义词典 :same_dict

索引(类数据库)

settings:设置索引库,定义索引库的分片数副本数等

映射(类表设计)

- 字段的数据类型

- 分词器类型

- 是否要进行存储或者创造索引

文档(数据)

- 全量更新用Put

- 局部更新用Post

3. 高级特性

映射高级

地理坐标点数据类型

地理坐标点是指地球表面可以用经纬度描述的一个点。

地理坐标点可以用来计算两个坐标间的距离,还可以判断一个坐标是否在一个区域中。地理坐标点需要显式声明对应字段类型为 geo_point

动态映射

使用dynamic mapping 来确定字段的数据类型并自动把新的字段添加到类型映射

DSL高级

查询所有(match_all query)

全文搜索(full-text query)

- 匹配搜索(match query)

- 短语搜索(match phrase query)

- 默认查询(query string)

- 多字段匹配搜索(multi match query)

词条级搜索(term-level query)

- 精确搜索term

- 集合搜索idx

- 范围搜索range

- 前缀搜索prefix

- 通配符搜索wildcard

- 正则搜索regexp

- 模糊搜索fuzzy

复合搜索

排序 sort &分页 size &高亮 highLight &批量 bluk

聚合分析

聚合分析是数据库中重要的功能特性,完成对一个查询的数据集中数据的聚合计算,如:找出某字段(或计算表达式的结果)的最大值、最小值,计算和、平均值等

- 对一个数据集求最大、最小、和、平均值等指标的聚合,在ES中称为 指标聚合 metric

- 对查询出的数据进行 分桶 group by,再在 桶 上进行指标 桶聚合 bucketing

智能搜索

- Term Suggester

- Phrase Suggester

- Completion Suggester

- Context Suggester

如果 Completion Suggester 已经到了零匹配,可以猜测用户有输入错误,这时候可以尝试一下 Phrase Suggester

。如果还是未匹配则尝试 Term Suggester 。

精准程度上( Precision )看: Completion > Phrase > Term, 而召回率上(Recall)则反之。

从性能上看,Completion Suggester是最快的,如果能满足业务需求,只用Completion Suggester做前缀匹配是最理想的。

Phrase和Term由于是做倒排索引的搜索,相比较而言性能应该要低不少,应尽量控制Suggester用到的索引的数据量,最理想的状况是经过一定时间预热后,索引可以全量map到内存。

4. 实战

写优化

- 副本数量 0

首次 初始化数据时,将副本设置为0,写入完毕再改回,避免了副本建立索引的过程

- 自动生成id

可以避免写前判断是否存在的过程

- 合理使用分词器

binary类型不适用,title和text使用不同的分词器加快速度

禁用评分,延长索引刷新间隔

将多个索引操作放入到batch进行处理

读优化

使用 Filter 代替Query,减少打分缓解,使用 bool 组合query和filter查询

对数据进行 分组 ,按照日,月,年不同维度分组,查询可集中在局部index中

零停机索引重建方案

外部数据导入

- 通过MQ的web控制台或cli命令行,发送指定的MQ消息

- MQ消息被微服务模块的消费者消费,触发ES数据重新导入功能

- 微服务模块从数据库里查询数据的总数及分页信息,并发送至MQ

- 微服务从MQ中根据分页信息从数据库获取到数据后,根据索引结构的定义,将数据组装成ES支持的JSON格式,并通过bulk命令将数据发送给Elasticsearch集群进行索引的重建工作。

基于Scroll+bulk+索引别名的方案

新建索引book_new,将mapping信息,settings信息等按新的要求全部定义好

使用scroll api将数据批量查询出来,指定scroll查询持续时间

采用bulk api将scoll查出来的一批数据,批量写入新索引

查询一批导入一批,注意每次都使用上次结束时的scoll_id

切换别名book_alias到新的索引book_new上面,此时Java客户端仍然使用别名访问,也不需要修

改任何代码,不需要停机。验证别名查询的是否为新索引的数据

Reindex API方案

- Elasticsearch v6.3.1已经支持Reindex API,它对scroll、bulk做了一层封装,能够 对文档重建索引而不需要任何插件或外部工具。

参与度 & 灵活性 :自研 > scroll+bulk > reindex

稳定性 & 可靠性 :自研 < scroll+bulk < reindex

DeepPaging性能解决方案

比如超级管理员,要给某个省份用户发送公告或者广告,最容易想到的就是利用 from + size 来实现,但这是不现实的